機器學(xué)習和深度學(xué)習綜述

- 分(fēn)類:行業新(xīn)聞

- 發布時間:2022-11-03 13:39:00

- 訪問量:931

機器學(xué)習和深度學(xué)習綜述

- 發布時間:2022-11-03 13:39:00

- 訪問量:931

機器學(xué)習和深度學(xué)習綜述

1. 人工(gōng)智能(néng)、機器學(xué)習、深度學(xué)習的關系

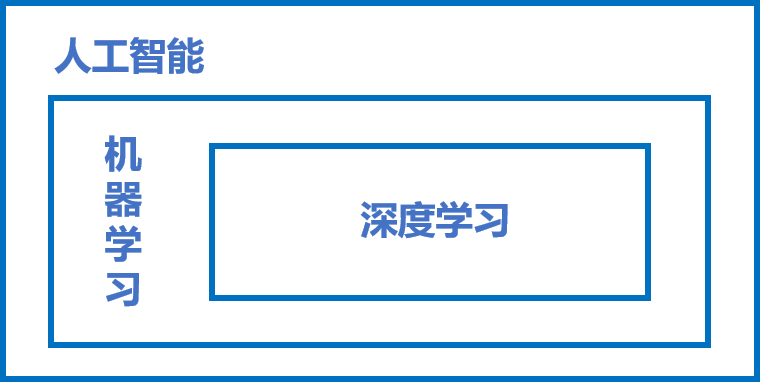

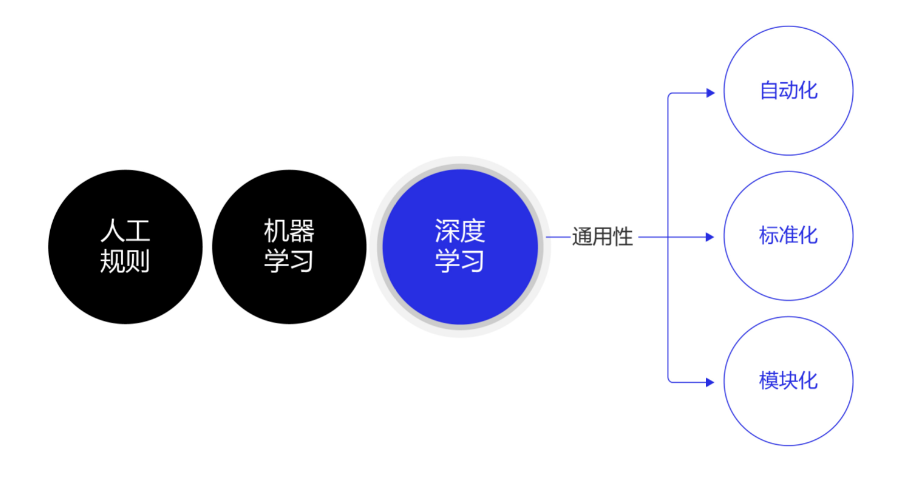

近些年人工(gōng)智能(néng)、機器學(xué)習和深度學(xué)習的概念十分(fēn)火熱,但很(hěn)多(duō)從業者卻很(hěn)難說清它們之間的關系,外行人更是霧裏看花(huā)。在研究深度學(xué)習之前,先從三個概念的正本清源開始。概括來說,人工(gōng)智能(néng)、機器學(xué)習和深度學(xué)習覆蓋的技(jì )術範疇是逐層遞減的,三者的關系如 圖1 所示,即:人工(gōng)智能(néng) > 機器學(xué)習 > 深度學(xué)習。

圖1:人工(gōng)智能(néng)、機器學(xué)習和深度學(xué)習三者關系示意

人工(gōng)智能(néng)(ArtificialIntelligence,AI)是最寬泛的概念,是研發用(yòng)于模拟、延伸和擴展人的智能(néng)的理(lǐ)論、方法、技(jì )術及應用(yòng)系統的一門新(xīn)的技(jì )術科(kē)學(xué)。由于這個定義隻闡述了目标,而沒有(yǒu)限定方法,因此實現人工(gōng)智能(néng)存在的諸多(duō)方法和分(fēn)支,導緻其變成一個“大雜燴”式的學(xué)科(kē)。機器學(xué)習(MachineLearning,ML)是當前比較有(yǒu)效的一種實現人工(gōng)智能(néng)的方式。深度學(xué)習(DeepLearning,DL)是機器學(xué)習算法中(zhōng)最熱門的一個分(fēn)支,近些年取得了顯著的進展,并替代了大多(duō)數傳統機器學(xué)習算法。

2. 機器學(xué)習

區(qū)别于人工(gōng)智能(néng),機器學(xué)習、尤其是監督學(xué)習則有(yǒu)更加明确的指代。機器學(xué)習是專門研究計算機怎樣模拟或實現人類的學(xué)習行為(wèi),以獲取新(xīn)的知識或技(jì )能(néng),重新(xīn)組織已有(yǒu)的知識結構,使之不斷改善自身的性能(néng)。這句話有(yǒu)點“雲山(shān)霧罩”的感覺,讓人不知所雲,下面我們從機器學(xué)習的實現和方法論兩個維度進行剖析,幫助讀者更加清晰地認識機器學(xué)習的來龍去脈。

2.1 機器學(xué)習的實現

機器學(xué)習的實現可(kě)以分(fēn)成兩步:訓練和預測,類似于歸納和演繹:

歸納: 從具(jù)體(tǐ)案例中(zhōng)抽象一般規律,機器學(xué)習中(zhōng)的“訓練”亦是如此。從一定數量的樣本(已知模型輸入和模型輸出)中(zhōng),學(xué)習輸出與輸入的關系(可(kě)以想象成是某種表達式)。

演繹: 從一般規律推導出具(jù)體(tǐ)案例的結果,機器學(xué)習中(zhōng)的“預測”亦是如此。基于訓練得到的與之間的關系,如出現新(xīn)的輸入,計算出輸出。通常情況下,如果通過模型計算的輸出和真實場景的輸出一緻,則說明模型是有(yǒu)效的。

2.2 機器學(xué)習的方法論

機器學(xué)習的方法論和人類科(kē)研的過程有(yǒu)着異曲同工(gōng)之妙,下面以“機器從牛頓第二定律實驗中(zhōng)學(xué)習知識”為(wèi)例,幫助讀者更加深入理(lǐ)解機器學(xué)習(監督學(xué)習)的方法論本質(zhì),即在“機器思考”的過程中(zhōng)确定模型的三個關鍵要素:假設、評價、優化。

2.2.1 案例:機器從牛頓第二定律實驗中(zhōng)學(xué)習知識

牛頓第二定律

牛頓第二定律是艾薩克·牛頓在1687年于《自然哲學(xué)的數學(xué)原理(lǐ)》一書中(zhōng)提出的,其常見表述:物(wù)體(tǐ)加速度的大小(xiǎo)跟作(zuò)用(yòng)力成正比,跟物(wù)體(tǐ)的質(zhì)量成反比,與物(wù)體(tǐ)質(zhì)量的倒數成正比。牛頓第二運動定律和第一、第三定律共同組成了牛頓運動定律,闡述了經典力學(xué)中(zhōng)基本的運動規律。

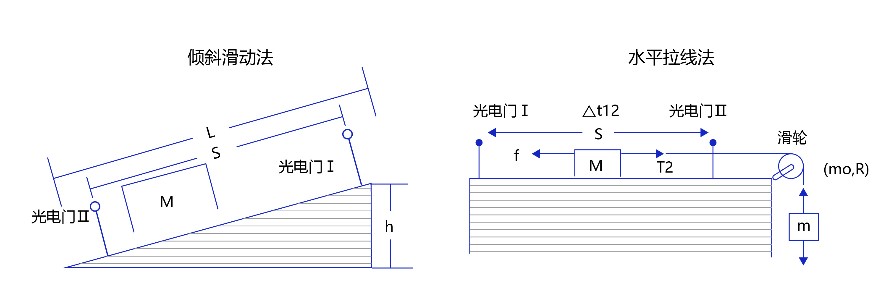

在中(zhōng)學(xué)課本中(zhōng),牛頓第二定律有(yǒu)兩種實驗設計方法:傾斜滑動法和水平拉線(xiàn)法,如 圖2 所示。

圖2:牛頓第二定律實驗設計方法

相信很(hěn)多(duō)讀者都有(yǒu)擺弄滑輪和小(xiǎo)木(mù)塊做物(wù)理(lǐ)實驗的青澀年代和美好回憶。通過多(duō)次實驗數據,可(kě)以統計出如 表1 所示的不同作(zuò)用(yòng)力下的木(mù)塊加速度。

表1:實驗獲取的大量數據樣本和觀測結果

觀察實驗數據不難猜測,物(wù)體(tǐ)的加速度和作(zuò)用(yòng)力之間的關系應該是線(xiàn)性關系。因此我們提出假設 ,其中(zhōng),代表加速度,代表作(zuò)用(yòng)力,是待确定的參數。

通過大量實驗數據的訓練,确定參數是物(wù)體(tǐ)質(zhì)量的倒數,即得到完整的模型公(gōng)式。當已知作(zuò)用(yòng)到某個物(wù)體(tǐ)的力時,基于模型可(kě)以快速預測物(wù)體(tǐ)的加速度。例如:燃料對火箭的推力=10,火箭的質(zhì)量=2,可(kě)快速得出火箭的加速度=5。

2.2.2 如何确定模型參數?

這個有(yǒu)趣的案例演示了機器學(xué)習的基本過程,但其中(zhōng)有(yǒu)一個關鍵點的實現尚不清晰,即:如何确定模型參數?

确定參數的過程與科(kē)學(xué)家提出假說的方式類似,合理(lǐ)的假說可(kě)以最大化的解釋所有(yǒu)的已知觀測數據。如果未來觀測到不符合理(lǐ)論假說的新(xīn)數據,科(kē)學(xué)家會嘗試提出新(xīn)的假說。如:天文(wén)史上,使用(yòng)大圓和小(xiǎo)圓組合的方式計算天體(tǐ)運行,在中(zhōng)世紀是可(kě)以拟合觀測數據的。但随着歐洲工(gōng)業革命的推動,天文(wén)觀測設備逐漸強大,已有(yǒu)的理(lǐ)論已經無法解釋越來越多(duō)的觀測數據,這促進了使用(yòng)橢圓計算天體(tǐ)運行的理(lǐ)論假說出現。因此,模型有(yǒu)效的基本條件是能(néng)夠拟合已知的樣本,這給我們提供了學(xué)習有(yǒu)效模型的實現方案。

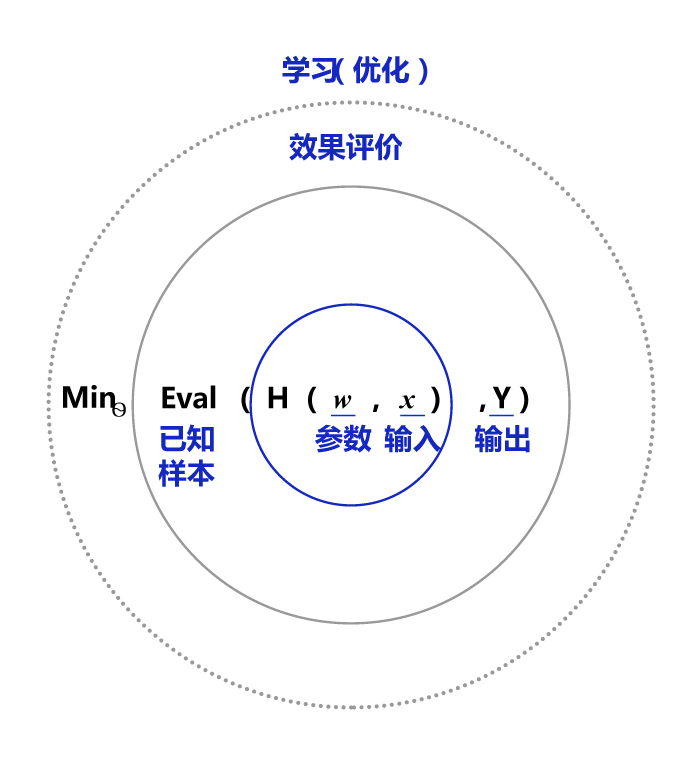

圖3 是以為(wèi)模型的假設,它是一個關于參數和輸入的函數,用(yòng) 表示。模型的優化目标是的輸出與真實輸出盡量一緻,兩者的相差程度即是模型效果的評價函數(相差越小(xiǎo)越好)。那麽,确定參數的過程就是在已知的樣本上,不斷減小(xiǎo)該評價函數(和的差距)的過程。直到模型學(xué)習到一個參數,使得評價函數的值最小(xiǎo),衡量模型預測值和真實值差距的評價函數也被稱為(wèi)損失函數(損失Loss)。

圖3:确定模型參數示意圖

假設機器通過嘗試答(dá)對(最小(xiǎo)化損失)大量的習題(已知樣本)來學(xué)習知識(模型參數),并期望用(yòng)學(xué)習到的知識所代表的模型,回答(dá)不知道答(dá)案的考試題(未知樣本)。最小(xiǎo)化損失是模型的優化目标,實現損失最小(xiǎo)化的方法稱為(wèi)優化算法,也稱為(wèi)尋解算法(找到使得損失函數最小(xiǎo)的參數解)。參數和輸入組成公(gōng)式的基本結構稱為(wèi)假設。在牛頓第二定律的案例中(zhōng),基于對數據的觀測,我們提出了線(xiàn)性假設,即作(zuò)用(yòng)力和加速度是線(xiàn)性關系,用(yòng)線(xiàn)性方程表示。由此可(kě)見,模型假設、評價函數(損失/優化目标)和優化算法是構成模型的三個關鍵要素。

2.2.3 模型結構

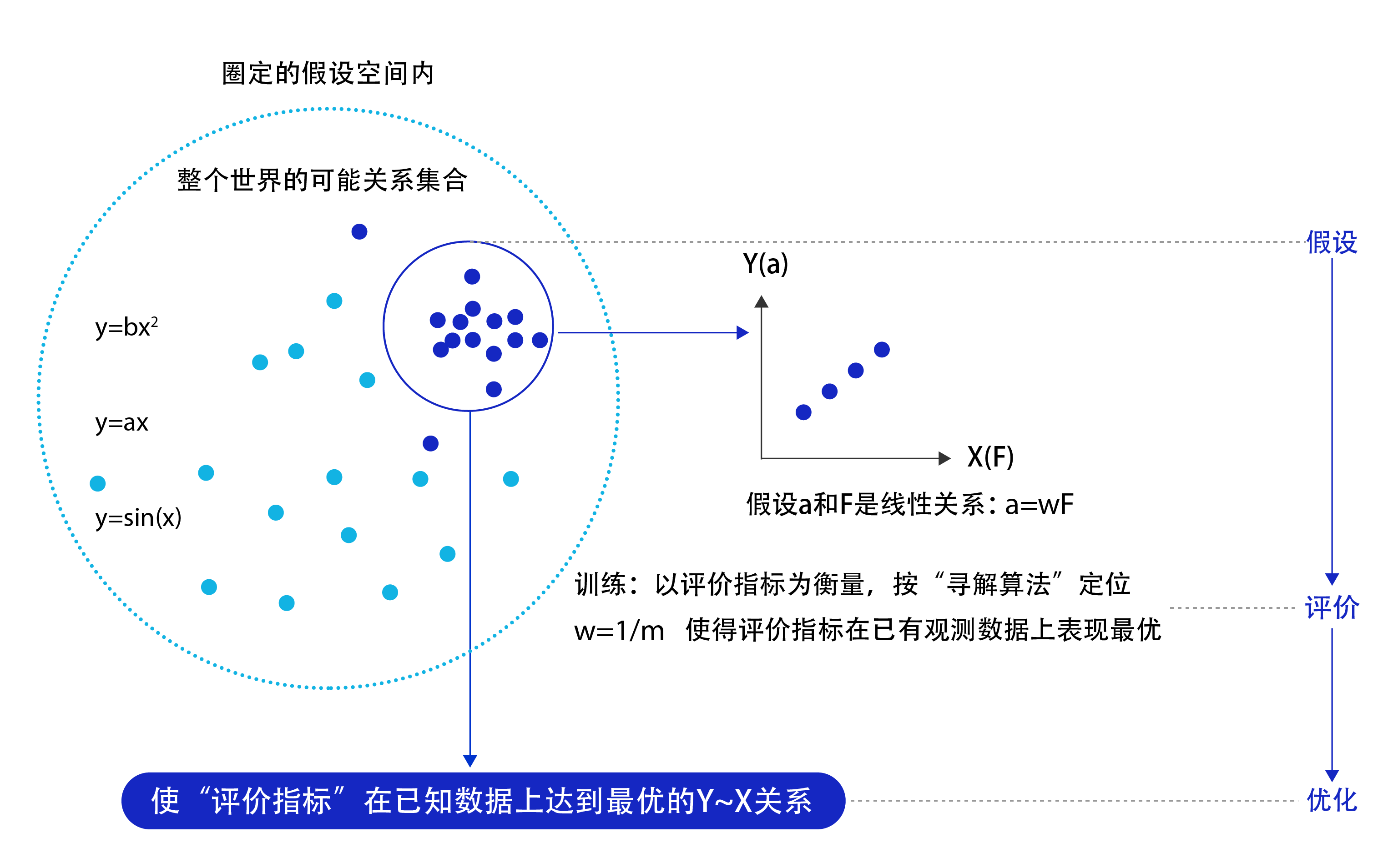

模型假設、評價函數和優化算法是如何支撐機器學(xué)習流程的呢(ne)?如圖4 所示。

圖4:機器學(xué)習流程

模型假設:世界上的可(kě)能(néng)關系千千萬,漫無目标的試探~之間的關系顯然是十分(fēn)低效的。因此假設空間先圈定了一個模型能(néng)夠表達的關系可(kě)能(néng),如藍色圓圈所示。機器還會進一步在假設圈定的圓圈内尋找最優的~關系,即确定參數。

評價函數:尋找最優之前,我們需要先定義什麽是最優,即評價一個~關系的好壞的指标。通常衡量該關系是否能(néng)很(hěn)好的拟合現有(yǒu)觀測樣本,将拟合的誤差最小(xiǎo)作(zuò)為(wèi)優化目标。

優化算法:設置了評價指标後,就可(kě)以在假設圈定的範圍内,将使得評價指标最優(損失函數最小(xiǎo)/最拟合已有(yǒu)觀測樣本)的~關系找出來,這個尋找最優解的方法即為(wèi)優化算法。最笨的優化算法即按照參數的可(kě)能(néng),窮舉每一個可(kě)能(néng)取值來計算損失函數,保留使得損失函數最小(xiǎo)的參數作(zuò)為(wèi)最終結果。

從上述過程可(kě)以得出,機器學(xué)習的過程與牛頓第二定律的學(xué)習過程基本一緻,都分(fēn)為(wèi)假設、評價和優化三個階段:

假設:通過觀察加速度和作(zuò)用(yòng)力的觀測數據,假設和是線(xiàn)性關系,即。

評價:對已知觀測數據上的拟合效果好,即計算的結果要和觀測的盡量接近。

優化:在參數的所有(yǒu)可(kě)能(néng)取值中(zhōng),發現可(kě)使得評價最好(最拟合觀測樣本)。

機器執行學(xué)習任務(wù)的框架體(tǐ)現了其學(xué)習的本質(zhì)是“參數估計”(Learning is parameter estimation)。

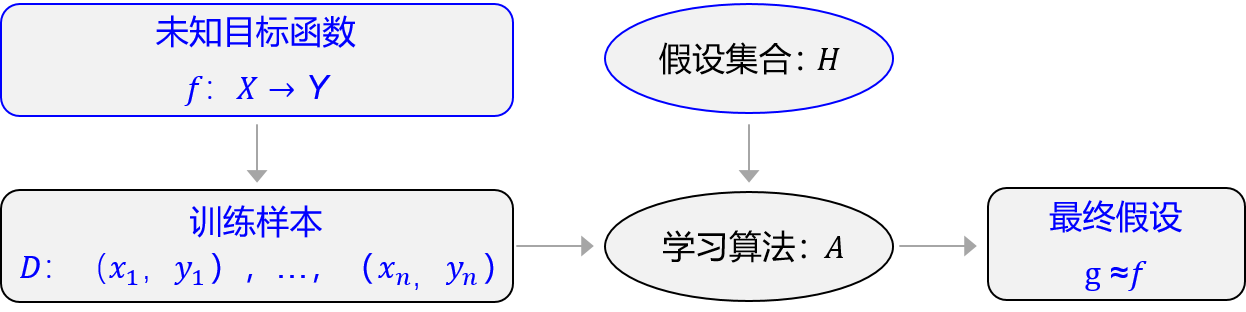

上述方法論使用(yòng)更規範化的表示如圖5所示,未知目标函數,以訓練樣本=為(wèi)依據。從假設集合中(zhōng),通過學(xué)習算法找到一個函數。如果能(néng)夠最大程度的拟合訓練樣本,那麽可(kě)以認為(wèi)函數就接近于目标函數。

圖5:規範化表示

在此基礎上,許多(duō)看起來完全不一樣的問題都可(kě)以使用(yòng)同樣的框架進行學(xué)習,如科(kē)學(xué)定律、圖像識别、機器翻譯和自動問答(dá)等,它們的學(xué)習目标都是拟合一個“大公(gōng)式f”,如 圖6 所示。

圖6:機器學(xué)習就是拟合一個“大公(gōng)式”

3. 深度學(xué)習

機器學(xué)習算法理(lǐ)論在上個世紀90年代發展成熟,在許多(duō)領域都取得了成功,但平靜的日子隻延續到2010年左右。随着大數據的湧現和計算機算力提升,深度學(xué)習模型異軍突起,極大改變了機器學(xué)習的應用(yòng)格局。今天,多(duō)數機器學(xué)習任務(wù)都可(kě)以使用(yòng)深度學(xué)習模型解決,尤其在語音、計算機視覺和自然語言處理(lǐ)等領域,深度學(xué)習模型的效果比傳統機器學(xué)習算法有(yǒu)顯著提升。

相比傳統的機器學(xué)習算法,深度學(xué)習做出了哪些改進呢(ne)?其實兩者在理(lǐ)論結構上是一緻的,即:模型假設、評價函數和優化算法,其根本差别在于假設的複雜度。如 圖6 第二個示例(圖像識别)所示,對于美女照片,人腦可(kě)以接收到五顔六色的光學(xué)信号,能(néng)快速反應出這張圖片是一位美女,而且是程序員喜歡的類型。但對計算機而言,隻能(néng)接收到一個數字矩陣,對于美女這種高級的語義概念,從像素到高級語義概念中(zhōng)間要經曆的信息變換的複雜性是難以想象的,如圖7所示。

圖7:深度學(xué)習的模型複雜度難以想象

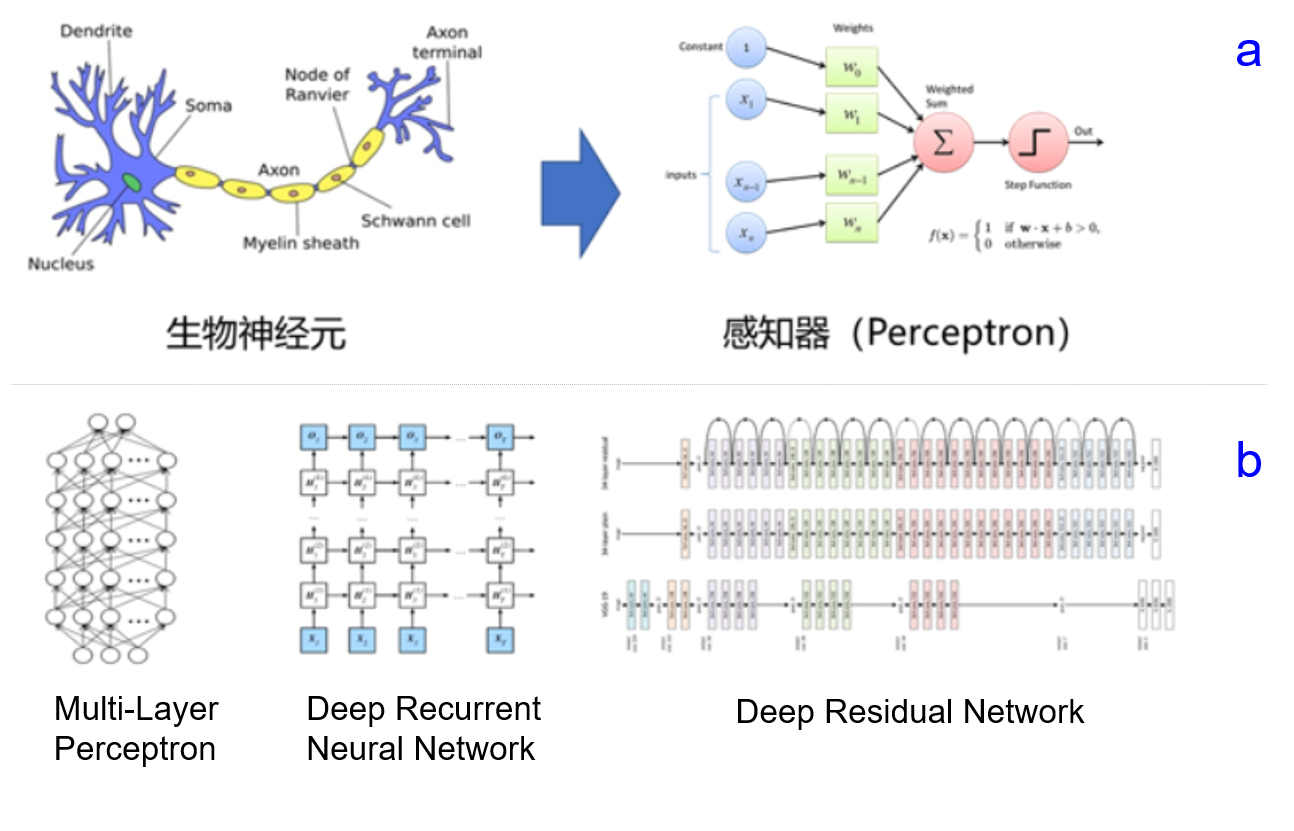

這種變換已經無法用(yòng)數學(xué)公(gōng)式表達,因此研究者們借鑒了人腦神經元的結構,設計出神經網絡的模型,如圖8所示。圖8(a)展示了神經網絡基本單元-感知機的設計方案,其處理(lǐ)信息的方式與人腦中(zhōng)的單一神經元有(yǒu)很(hěn)強的相似性;圖8(b)展示了幾種經典的神經網絡結構(後續的章節中(zhōng)會詳細闡述),類似于人腦中(zhōng)多(duō)種基于大量神經元連接而形成的不同職能(néng)的器官。

圖8:模拟人腦結構,針對各種任務(wù)設計不同的深度學(xué)習模型

3.1 神經網絡的基本概念

人工(gōng)神經網絡包括多(duō)個神經網絡層,如:卷積層、全連接層、LSTM等,每一層又(yòu)包括很(hěn)多(duō)神經元,超過三層的非線(xiàn)性神經網絡都可(kě)以被稱為(wèi)深度神經網絡。通俗的講,深度學(xué)習的模型可(kě)以視為(wèi)是輸入到輸出的映射函數,如圖像到高級語義(美女)的映射,足夠深的神經網絡理(lǐ)論上可(kě)以拟合任何複雜的函數。因此神經網絡非常适合學(xué)習樣本數據的内在規律和表示層次,對文(wén)字、圖像和語音任務(wù)有(yǒu)很(hěn)好的适用(yòng)性。這幾個領域的任務(wù)是人工(gōng)智能(néng)的基礎模塊,因此深度學(xué)習被稱為(wèi)實現人工(gōng)智能(néng)的基礎也就不足為(wèi)奇了。

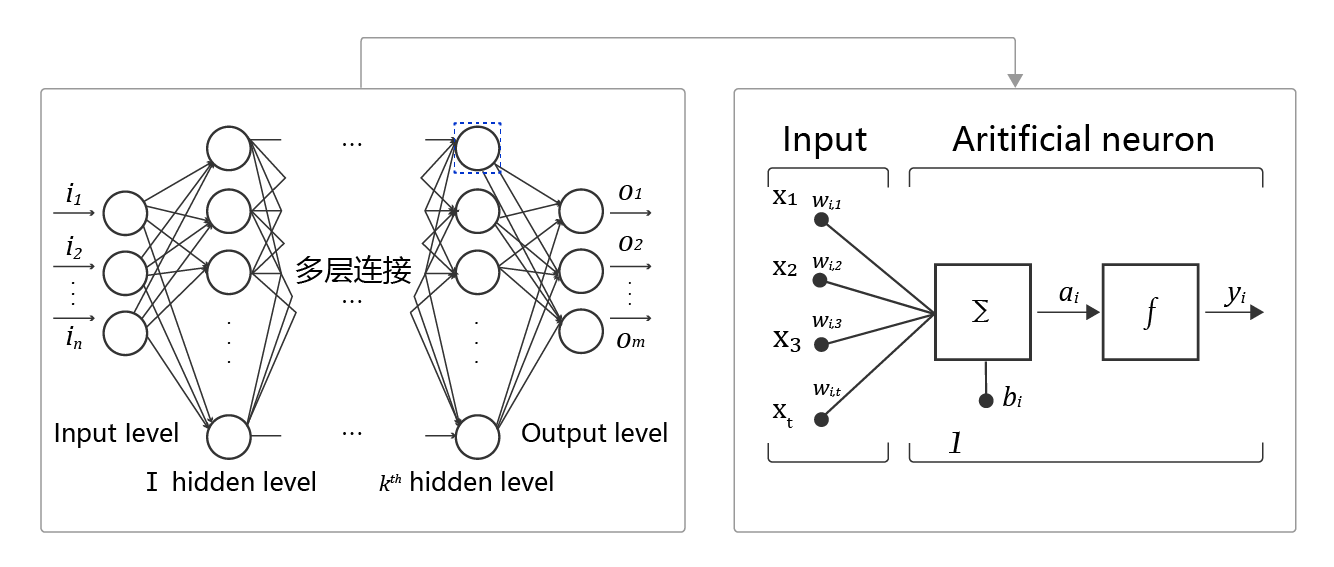

神經網絡基本結構如 圖9 所示。

圖9:神經網絡基本結構示意圖

神經元: 神經網絡中(zhōng)每個節點稱為(wèi)神經元,由兩部分(fēn)組成:

加權和:将所有(yǒu)輸入加權求和。

非線(xiàn)性變換(激活函數):加權和的結果經過一個非線(xiàn)性函數變換,讓神經元計算具(jù)備非線(xiàn)性的能(néng)力。

多(duō)層連接: 大量這樣的節點按照不同的層次排布,形成多(duō)層的結構連接起來,即稱為(wèi)神經網絡。

前向計算: 從輸入計算輸出的過程,順序從網絡前至後。

計算圖: 以圖形化的方式展現神經網絡的計算邏輯又(yòu)稱為(wèi)計算圖,也可(kě)以将神經網絡的計算圖以公(gōng)式的方式表達:

由此可(kě)見,神經網絡并沒有(yǒu)那麽神秘,它的本質(zhì)是一個含有(yǒu)很(hěn)多(duō)參數的“大公(gōng)式”。如果大家感覺這些概念仍過于抽象,理(lǐ)解的不夠透徹,先不用(yòng)着急,下一章會以“房價預測”為(wèi)例,演示使用(yòng)Python實現神經網絡模型的細節。

3.2 深度學(xué)習的發展曆程

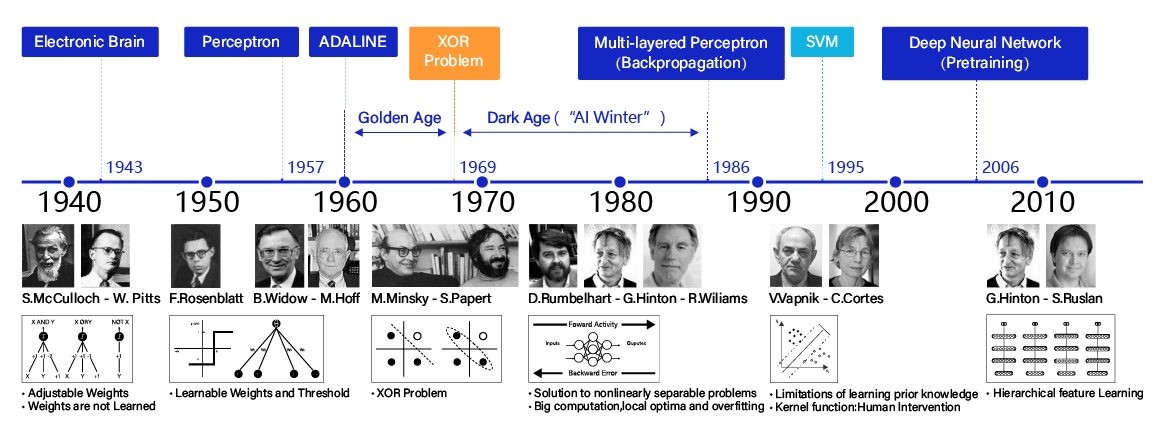

神經網絡思想的提出已經是70多(duō)年前的事情了,現今的神經網絡和深度學(xué)習的設計理(lǐ)論是一步步趨于完善的。在這漫長(cháng)的發展歲月中(zhōng),一些取得關鍵突破的閃光時刻,值得深度學(xué)習愛好者們銘記,如 圖10 所示。

圖10:深度學(xué)習發展曆程

1940年代:首次提出神經元的結構,但權重是不可(kě)學(xué)的。

50-60年代:提出權重學(xué)習理(lǐ)論,神經元結構趨于完善,開啓了神經網絡的第一個黃金時代。

1969年:提出異或問題(人們驚訝的發現神經網絡模型連簡單的異或問題也無法解決,對其的期望從雲端跌落到谷底),神經網絡模型進入了被束之高閣的黑暗時代。

1986年:新(xīn)提出的多(duō)層神經網絡解決了異或問題,但随着90年代後理(lǐ)論更完備并且實踐效果更好的SVM等機器學(xué)習模型的興起,神經網絡并未得到重視。

2010年左右:深度學(xué)習進入真正興起時期。随着神經網絡模型改進的技(jì )術在語音和計算機視覺任務(wù)上大放異彩,也逐漸被證明在更多(duō)的任務(wù),如自然語言處理(lǐ)以及海量數據的任務(wù)上更加有(yǒu)效。至此,神經網絡模型重新(xīn)煥發生機,并有(yǒu)了一個更加響亮的名(míng)字:深度學(xué)習。

為(wèi)何神經網絡到2010年後才煥發生機呢(ne)?這與深度學(xué)習成功所依賴的先決條件:大數據湧現、硬件發展和算法優化有(yǒu)關。

大數據是神經網絡發展的有(yǒu)效前提。神經網絡和深度學(xué)習是非常強大的模型,需要足夠量級的訓練數據。時至今日,之所以很(hěn)多(duō)傳統機器學(xué)習算法和人工(gōng)特征依然是足夠有(yǒu)效的方案,原因在于很(hěn)多(duō)場景下沒有(yǒu)足夠的标記數據來支撐深度學(xué)習。深度學(xué)習的能(néng)力特别像科(kē)學(xué)家阿基米德(dé)的豪言壯語:“給我一根足夠長(cháng)的杠杆,我能(néng)撬動地球!”。深度學(xué)習也可(kě)以發出類似的豪言:“給我足夠多(duō)的數據,我能(néng)夠學(xué)習任何複雜的關系”。但在現實中(zhōng),足夠長(cháng)的杠杆與足夠多(duō)的數據一樣,往往隻能(néng)是一種美好的願景。直到近些年,各行業IT化程度提高,累積的數據量爆發式地增長(cháng),才使得應用(yòng)深度學(xué)習模型成為(wèi)可(kě)能(néng)。

依靠硬件的發展和算法的優化。現階段,依靠更強大的計算機、GPU、autoencoder預訓練和并行計算等技(jì )術,深度學(xué)習在模型訓練上的困難已經被逐漸克服。其中(zhōng),數據量和硬件是更主要的原因。沒有(yǒu)前兩者,科(kē)學(xué)家們想優化算法都無從進行。

3.3 深度學(xué)習的研究和應用(yòng)蓬勃發展

早在1998年,一些科(kē)學(xué)家就已經使用(yòng)神經網絡模型識别手寫數字圖像了。但深度學(xué)習在計算機視覺應用(yòng)上的興起,還是在2012年ImageNet比賽上,使用(yòng)AlexNet做圖像分(fēn)類。如果比較下1998年和2012年的模型,會發現兩者在網絡結構上非常類似,僅在細節上有(yǒu)所優化。在這十四年間,計算性能(néng)的大幅提升和數據量的爆發式增長(cháng),促使模型完成了從“簡單的數字識别”到“複雜的圖像分(fēn)類”的跨越。

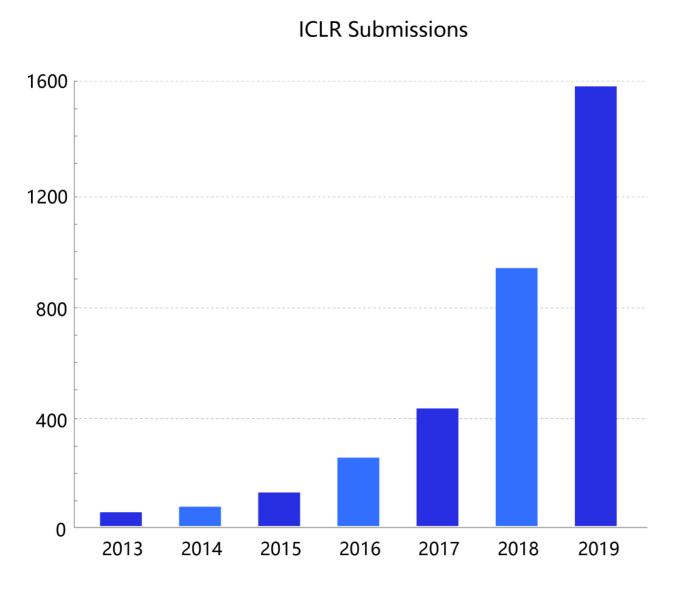

雖然曆史悠久,但深度學(xué)習在今天依然在蓬勃發展,一方面基礎研究快速發展,另一方面工(gōng)業實踐層出不窮。基于深度學(xué)習的頂級會議ICLR(International Conference on Learning Representations)統計,深度學(xué)習相關的論文(wén)數量呈逐年遞增的狀态,如 圖11 所示。同時,不僅僅是深度學(xué)習會議,與數據和模型技(jì )術相關的會議ICML和KDD,專注視覺的CVPR和專注自然語言處理(lǐ)的EMNLP等國(guó)際會議的大量論文(wén)均涉及着深度學(xué)習技(jì )術。該領域和相關領域的研究方興未艾,技(jì )術仍在不斷創新(xīn)突破中(zhōng)。

圖11:深度學(xué)習相關論文(wén)數量逐年攀升

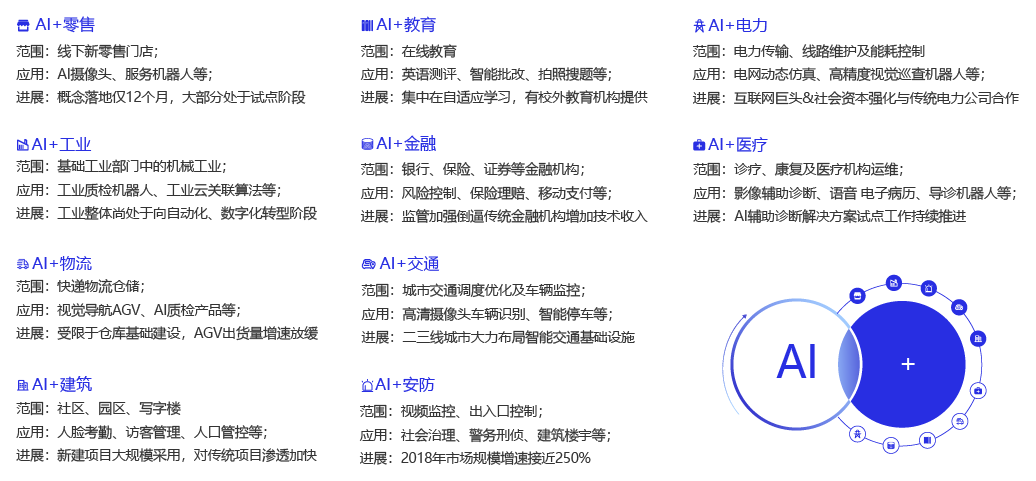

另一方面,以深度學(xué)習為(wèi)基礎的人工(gōng)智能(néng)技(jì )術,在升級改造衆多(duō)的傳統行業領域,存在極其廣闊的應用(yòng)場景。圖12 選自艾瑞咨詢的研究報告,人工(gōng)智能(néng)技(jì )術不僅可(kě)在衆多(duō)行業中(zhōng)落地應用(yòng)(廣度),同時,在部分(fēn)行業(如安(ān)防、遙感、互聯網、金融、工(gōng)業等)已經實現了市場化變現和高速增長(cháng)(深度),為(wèi)社會貢獻了巨大的經濟價值。

圖12:以深度學(xué)習為(wèi)基礎的AI技(jì )術在各行業廣泛應用(yòng)

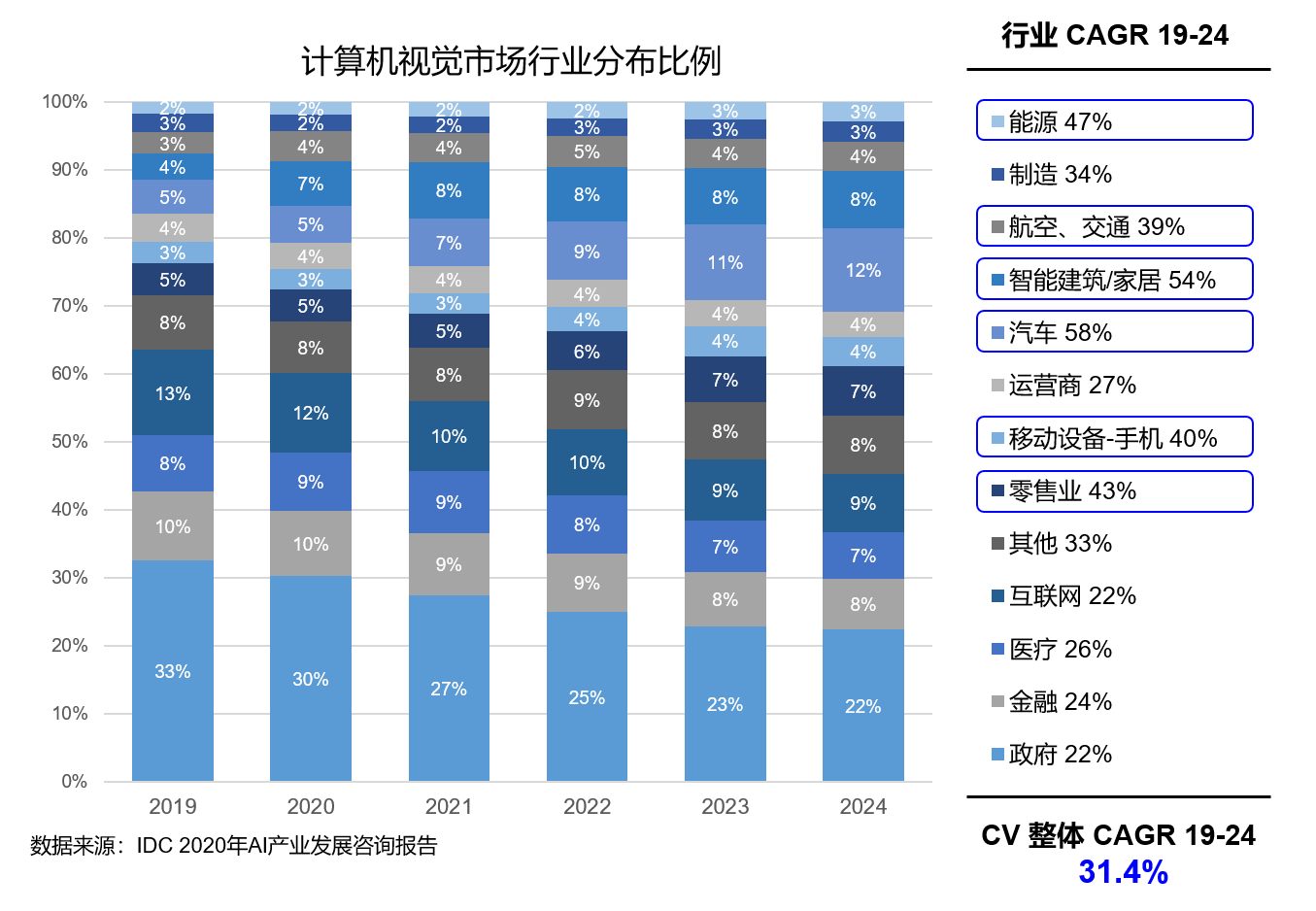

如圖13所示,以計算機視覺的行業應用(yòng)分(fēn)布為(wèi)例,根據IDC的數據統計和預測,随着人工(gōng)智能(néng)向各個行業的滲透,當前較多(duō)運用(yòng)人工(gōng)智能(néng)的互聯網行業的産(chǎn)值占比反而會逐漸變小(xiǎo)。

圖13:以深度學(xué)習為(wèi)基礎的AI技(jì )術在各行業廣泛應用(yòng)

3.4 深度學(xué)習改變了AI應用(yòng)的研發模式

3.4.1 實現了端到端的學(xué)習

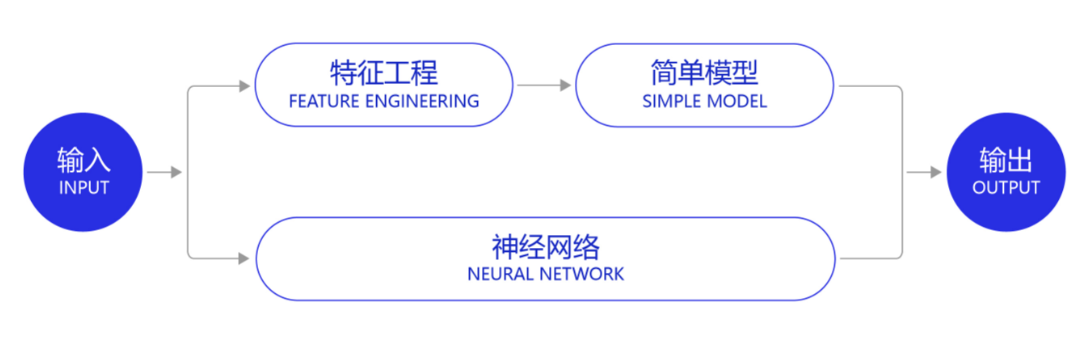

深度學(xué)習改變了很(hěn)多(duō)領域算法的實現模式。在深度學(xué)習興起之前,很(hěn)多(duō)領域建模的思路是投入大量精(jīng)力做特征工(gōng)程,将專家對某個領域的“人工(gōng)理(lǐ)解”沉澱成特征表達,然後使用(yòng)簡單模型完成任務(wù)(如分(fēn)類或回歸)。而在數據充足的情況下,深度學(xué)習模型可(kě)以實現端到端的學(xué)習,即不需要專門做特征工(gōng)程,将原始的特征輸入模型中(zhōng),模型可(kě)同時完成特征提取和分(fēn)類任務(wù),如 圖14 所示。

圖14:深度學(xué)習實現了端到端的學(xué)習

以計算機視覺任務(wù)為(wèi)例,特征工(gōng)程是諸多(duō)圖像科(kē)學(xué)家基于人類對視覺理(lǐ)論的理(lǐ)解,設計出來的一系列提取特征的計算步驟,典型如SIFT特征。在2010年之前的計算機視覺領域,人們普遍使用(yòng)SIFT一類特征+SVM一類的簡單淺層模型完成建模任務(wù)。

說明:

SIFT特征由David Lowe在1999年提出,在2004年加以完善。SIFT特征是基于物(wù)體(tǐ)上的一些局部外觀的興趣點而與影像的大小(xiǎo)和旋轉無關。對于光線(xiàn)、噪聲、微視角改變的容忍度也相當高。基于這些特性,它們是高度顯著而且相對容易撷取,在母數龐大的特征數據庫中(zhōng),很(hěn)容易辨識物(wù)體(tǐ)而且鮮有(yǒu)誤認。使用(yòng)SIFT特征描述對于部分(fēn)物(wù)體(tǐ)遮蔽的偵測率也相當高,甚至隻需要3個以上的SIFT物(wù)體(tǐ)特征就足以計算出位置與方位。在現今的電(diàn)腦硬件速度下和小(xiǎo)型的特征數據庫條件下,辨識速度可(kě)接近即時運算。SIFT特征的信息量大,适合在海量數據庫中(zhōng)快速準确匹配。

3.4.2 實現了深度學(xué)習框架标準化

除了應用(yòng)廣泛的特點外,深度學(xué)習還推動人工(gōng)智能(néng)進入工(gōng)業大生産(chǎn)階段,算法的通用(yòng)性導緻标準化、自動化和模塊化的框架産(chǎn)生,如 圖15 所示。

圖15:深度學(xué)習模型具(jù)有(yǒu)通用(yòng)性特點

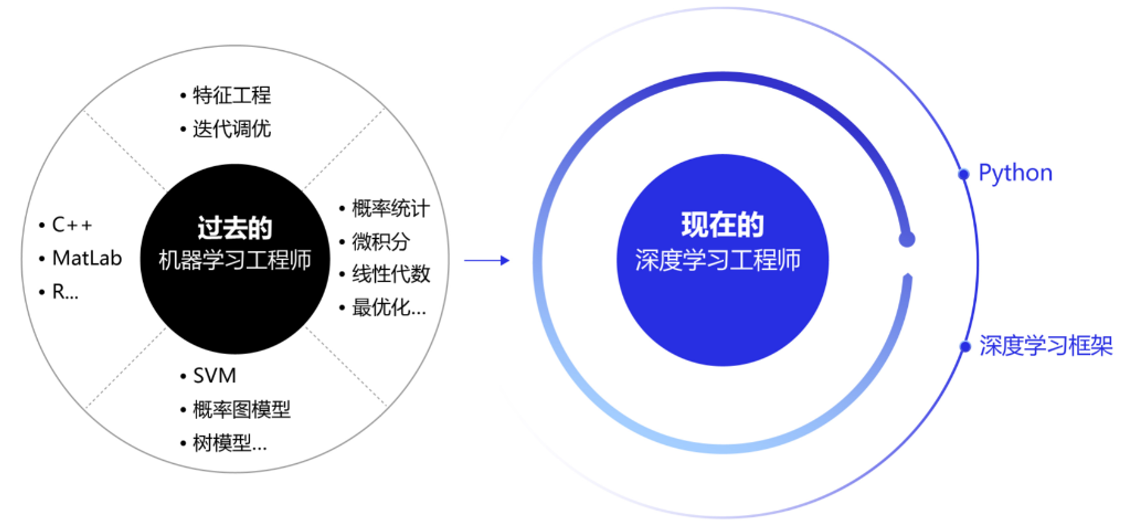

在此之前,不同流派的機器學(xué)習算法理(lǐ)論和實現均不同,導緻每個算法均要獨立實現,如随機森林和支撐向量機(SVM)。但在深度學(xué)習框架下,不同模型的算法結構有(yǒu)較大的通用(yòng)性,如常用(yòng)于計算機視覺的卷積神經網絡模型(CNN)和常用(yòng)于自然語言處理(lǐ)的長(cháng)期短期記憶模型(LSTM),都可(kě)以分(fēn)為(wèi)組網模塊、梯度下降的優化模塊和預測模塊等。這使得抽象出統一的框架成為(wèi)了可(kě)能(néng),并大大降低了編寫建模代碼的成本。一些相對通用(yòng)的模塊,如網絡基礎算子的實現、各種優化算法等都可(kě)以由框架實現。建模者隻需要關注數據處理(lǐ),配置組網的方式,以及用(yòng)少量代碼串起訓練和預測的流程即可(kě)。

在深度學(xué)習框架出現之前,機器學(xué)習工(gōng)程師處于“手工(gōng)作(zuò)坊”生産(chǎn)的時代。為(wèi)了完成建模,工(gōng)程師需要儲備大量數學(xué)知識,并為(wèi)特征工(gōng)程工(gōng)作(zuò)積累大量行業知識。每個模型是極其個性化的,建模者如同手工(gōng)業者一樣,将自己的積累形成模型的“個性化簽名(míng)”。而今,“深度學(xué)習工(gōng)程師”進入了工(gōng)業化大生産(chǎn)時代,隻要掌握深度學(xué)習必要但少量的理(lǐ)論知識,掌握Python編程,即可(kě)在深度學(xué)習框架上實現非常有(yǒu)效的模型,甚至與該領域最領先的模型不相上下。建模領域的技(jì )術壁壘面臨着颠覆,也是新(xīn)入行者的機遇。

圖16:深度學(xué)習框架大大減低了AI建模難度

4. 人工(gōng)智能(néng)的職業發展空間廣闊

哲學(xué)家們告訴我們,做我們所喜歡的,然後成功就會随之而來。

—— 沃倫 · 巴菲特 (全球著名(míng)的投資家)

相信本課程的讀者中(zhōng)有(yǒu)很(hěn)多(duō)在校籌備找工(gōng)作(zuò)的同學(xué)和職場中(zhōng)期望轉型的工(gōng)程師, 大家普遍對人工(gōng)智能(néng)的職業發展非常關心。下面就從經濟回報的視角,分(fēn)析下人工(gōng)智能(néng)是不是一個有(yǒu)前途的職業。坦率的說,如巴菲特所言,選擇一個自己喜歡的職業是真正的好職業。但對于多(duō)數普通人,經濟回報也是職業選擇的重要考慮因素。一個有(yǒu)高經濟回報的職業一定是市場需求遠(yuǎn)遠(yuǎn)大于市場供給的職業,且市場需求要保持長(cháng)期的增長(cháng),而市場供給難以中(zhōng)短期得到補充。

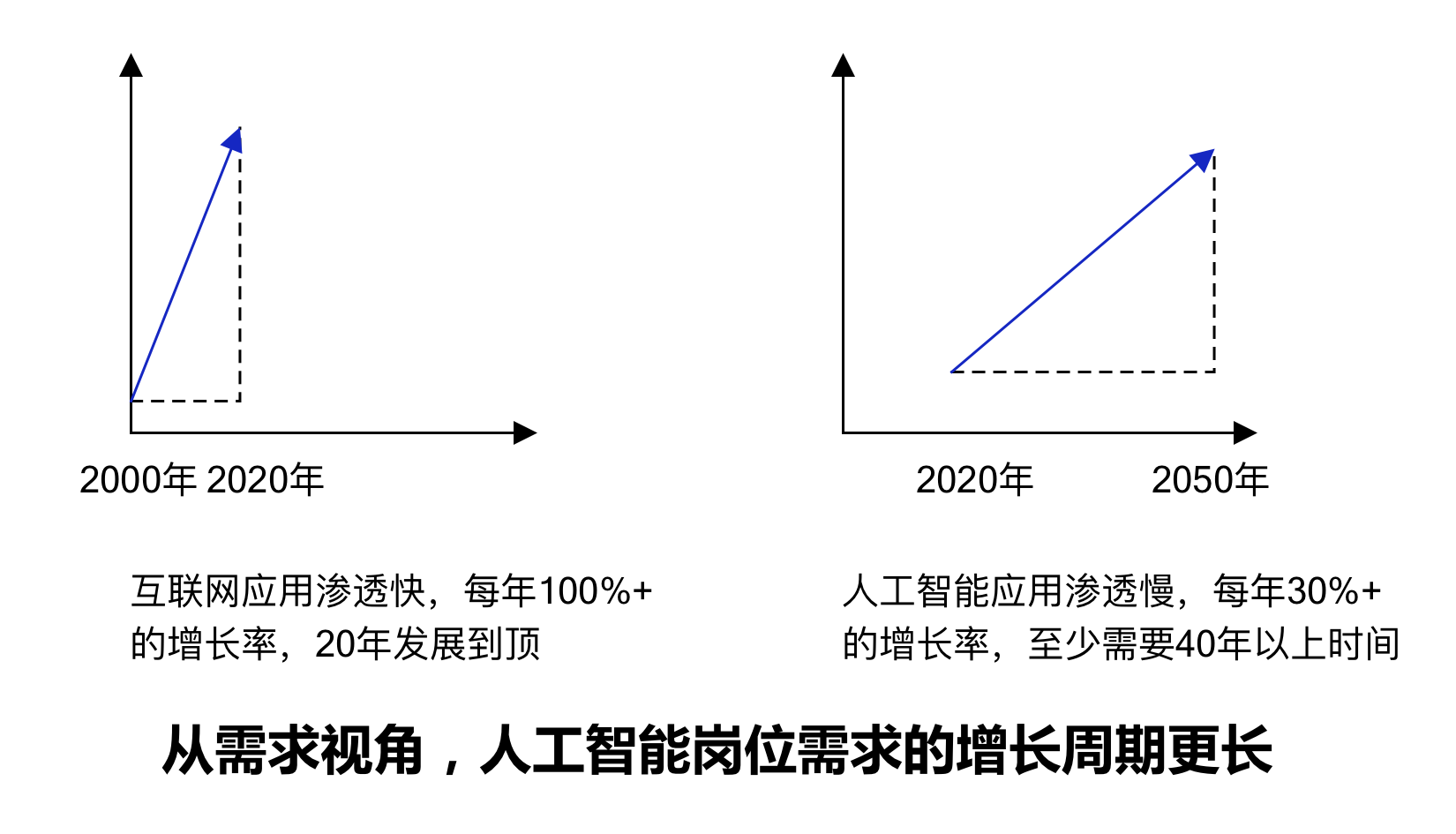

人工(gōng)智能(néng)崗位的市場需求旺盛

根據各大咨詢公(gōng)司的行業研究報告,人工(gōng)智能(néng)相關産(chǎn)業在未來十年預計有(yǒu)30%~40%的年增長(cháng)率。一方面,人工(gōng)智能(néng)的應用(yòng)會從互聯網行業逐漸擴展到金融、工(gōng)業、農業、能(néng)源、城市、交通、醫(yī)療、教育等更廣泛的行業,應用(yòng)空間和潛力巨大;另一方面,受限于工(gōng)智能(néng)技(jì )術本身的成熟度以及人工(gōng)智能(néng)落地要結合場景的數據處理(lǐ)、系統改造和業務(wù)流程優化等條件的制約,人工(gōng)智能(néng)應用(yòng)的價值釋放過程會相對緩慢。這使得市場對人工(gōng)智能(néng)的崗位需求形成了一條穩步又(yòu)長(cháng)期增長(cháng)的曲線(xiàn),與互聯網行業相比,對多(duō)數的求職者更加友好,如圖17所示。

互聯網行業由于技(jì )術成熟周期短,應用(yòng)落地的推進速度快,反而形成一條增長(cháng)率更高(年增長(cháng)率超過100%)但增長(cháng)周期更短的曲線(xiàn)(電(diàn)腦互聯網時代10年,移動互聯網時代10年)。當行業增長(cháng)達到頂峰,對崗位的需求也會相應回落,如同2021年底的互聯網行業的現狀。

圖17:人工(gōng)智能(néng)崗位的市場供給對比

複合型人才成為(wèi)市場剛需

在人工(gōng)智能(néng)落地到千行萬業的過程中(zhōng),企業需求量最大、也最為(wèi)迫切的是既懂行業知識和場景,又(yòu)懂人工(gōng)智能(néng)理(lǐ)論,還具(jù)備實踐能(néng)力和經驗的“複合型人才”。成為(wèi)“複合型人才”不僅需要學(xué)習書本知識,還要大量進行産(chǎn)業實踐,使得這種人才有(yǒu)成長(cháng)深度,供給增長(cháng)緩慢。從上述分(fēn)析可(kě)見,當人工(gōng)智能(néng)産(chǎn)業在未來幾十年保持穩定的增長(cháng),而産(chǎn)業需要的“複合型人才”又(yòu)難以大量供給的情況下,人工(gōng)智能(néng)應用(yòng)研發崗位會維持一個很(hěn)好的經濟回報。

人生天地之間,若白駒過隙,忽然而已,每個人都希望留下自己的足迹。為(wèi)何要學(xué)習深度學(xué)習技(jì )術,以及如何通過這本書來學(xué)習呢(ne)?一方面,深度學(xué)習的應用(yòng)前景廣闊,是極好的發展方向和職業選擇。另一方面,本書會使用(yòng)國(guó)産(chǎn)的深度學(xué)習框架飛槳(PaddlePaddle)來編寫實踐案例,基于框架的編程讓深度學(xué)習變得易學(xué)易用(yòng)。

熱點資訊

航标遙測遙控系統

機器學(xué)習和深度學(xué)習綜述

聯系我們

電(diàn)話:021-64026238

郵箱:

地址:上海闵行區(qū)興梅路485号201

掃一掃,加為(wèi)好友。

021-64026238

021-64026238

在線(xiàn)留言

在線(xiàn)留言